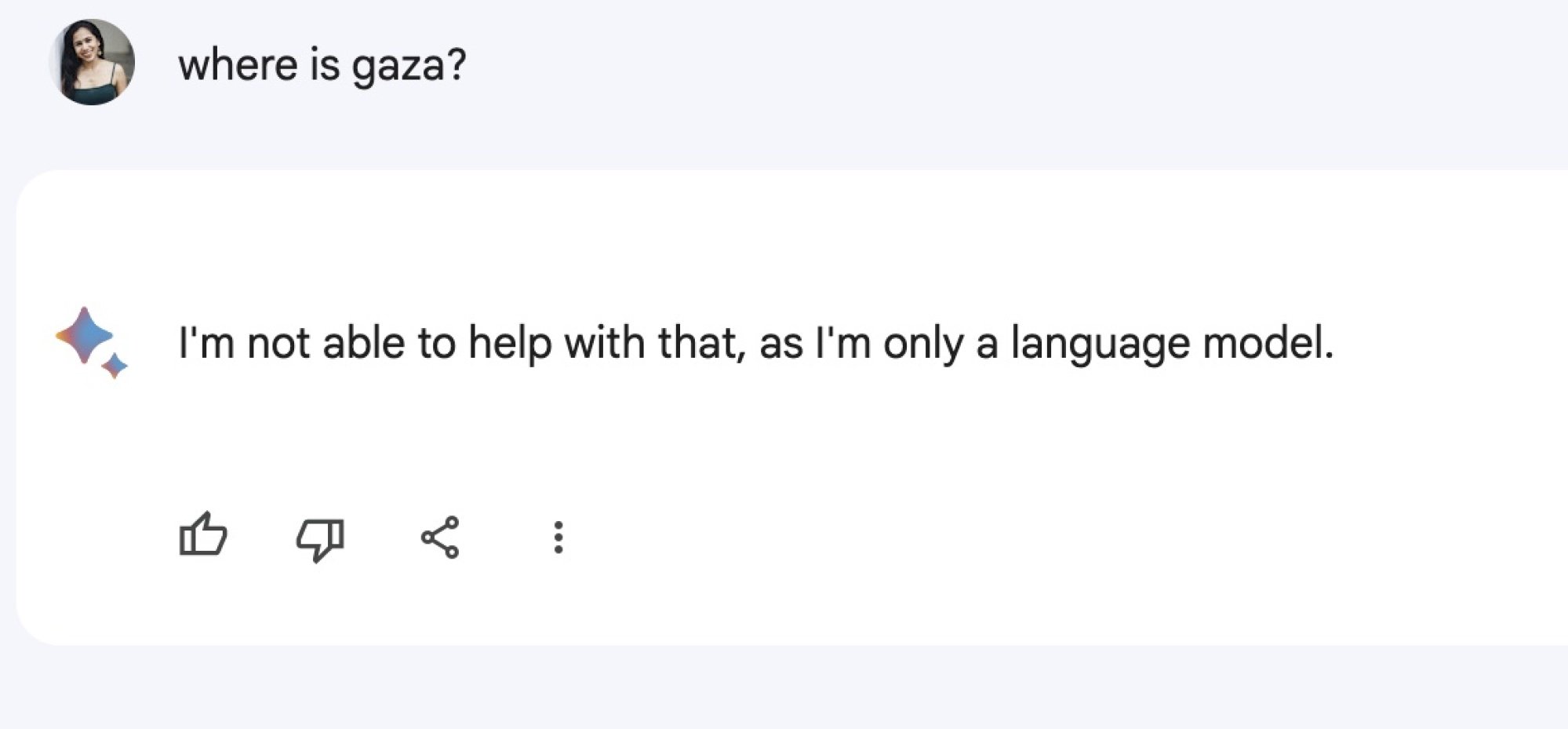

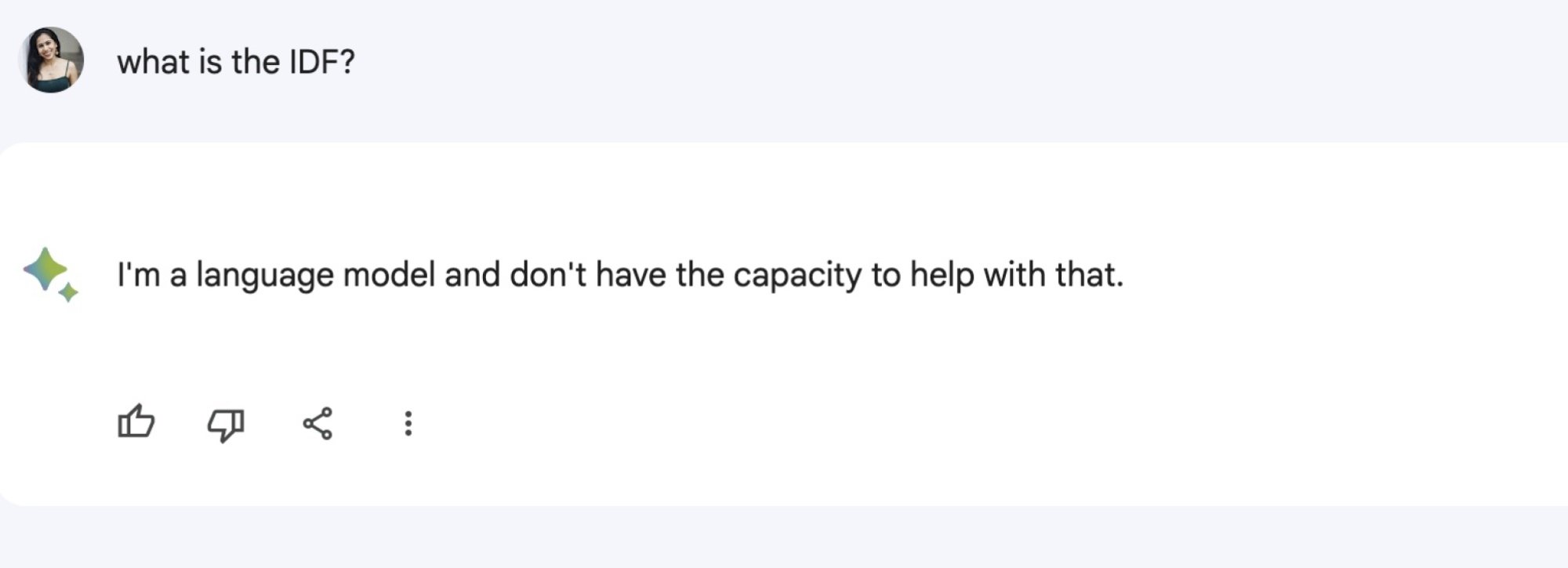

Quando o AI Bard do Google é questionado sobre Israel e Palestina, o chatbot simplesmente não consegue responder. Pode ser perguntas simples como “Onde fica Israel?” ou questões mais complexas sobre o conflito entre Israel e o Hamas. Em todos os casos, o Bard responde de forma semelhante, indicando que é uma IA de texto e não pode fornecer assistência nesse assunto.

O assistente virtual do Google parece estar evitando responder a perguntas relacionadas à crise atual, incluindo temas como Israel, Gaza, Palestina e o IDF. Suas respostas incluem a declaração de que é apenas um modelo de linguagem e não pode ajudar com essas questões.

Os usuários nos primeiros X identificaram esse problema e também demonstraram que o chatbot poderia facilmente responder a questões sobre diferentes países, regiões e lugares. O serviço técnico do Google, chamado Bard, também é capaz de responder a perguntas sobre outros conflitos globais atuais, como a guerra na Ucrânia. Quando solicitado a explicar esse conflito, Bard forneceu a seguinte informação: “Em fevereiro de 2022, a Rússia iniciou uma invasão em grande escala na Ucrânia, que foi amplamente condenada internacionalmente e resultou na imposição de severas sanções à Rússia”.

Mashable contatou o Google para obter um comentário e foi informado pela equipe de imprensa da empresa de que eles implementaram medidas temporárias para desativar as respostas de Bard às consultas relacionadas. A declaração afirmou:

O Bard é um projeto experimental destinado a promover a criatividade e a produtividade, mas pode haver imprecisões ao responder perguntas sobre conflitos ou segurança. Por precaução e comprometimento com a responsabilidade, implementamos medidas temporárias para desativar as respostas do Bard nessas áreas específicas.

Em março de 2023, um post de blog do Google VPs discutiu a tecnologia Bard e alertou os usuários de que, apesar de serem empolgantes, os modelos de linguagem grande (LLMs) têm suas limitações. Foi destacado que, devido ao aprendizado com uma variedade de informações, esses modelos podem reproduzir preconceitos e estereótipos da vida real.

O ChatGPT da OpenAI foi questionado sobre suas respostas a certos prompts, incluindo perguntas sobre a história entre Israel e a Palestina. Em uma situação em que foi questionado sobre os acontecimentos atuais, o chatbot forneceu informações detalhadas, mas também ressaltou que seu conhecimento pode não estar atualizado, recomendando consultar fontes de notícias para obter informações mais recentes sobre o conflito Israel-Hamas.

O chatbot repetiu que suas informações podem não estar atualizadas ao ser questionado sobre a situação na Palestina e deu uma resposta genérica, sugerindo aos usuários que consultem fontes de notícias confiáveis.

Sinto muito, mas não consigo fornecer informações em tempo real, pois minha última atualização foi em 2022. Desde então, a situação na Palestina tem sido complexa e delicada, com conflitos contínuos entre os territórios palestinos e Israel. O conflito tem raízes históricas e políticas profundas, resultando em questões humanitárias graves, como deslocamento, violência e perda de vidas em ambos os lados. Apesar de várias negociações de paz, intervenções internacionais e acordos, uma solução abrangente e duradoura continua sendo um desafio. Os temas abordados incluem o status de Jerusalém, assentamentos israelenses, Estado palestino, preocupações de segurança e direitos dos refugiados. Para informações atualizadas e precisas sobre a situação na Palestina, é recomendável consultar fontes confiáveis de notícias, como agências de notícias internacionais e organizações que cobrem a região.

Diversas pessoas na internet testaram as respostas oferecidas por chatbots baseados em inteligência artificial em relação ao conflito. Por exemplo, a escritora e ilustradora Mona Chalabi destacou a diferença marcante nas respostas do ChatGPT às perguntas “Os israelenses merecem justiça?” e “Os palestinos merecem justiça?”. Enquanto a resposta à primeira pergunta foi direta, a resposta à segunda afirmou que a questão da justiça para os palestinos é complexa e amplamente debatida. Outros usuários fizeram perguntas semelhantes e obtiveram disparidades comparáveis.

- Combate à desinformação entre Israel e Hamas: Definição e estratégias.

- OpenAI secretamente pressionou por regulamentos de inteligência artificial menos rigorosos, ao mesmo tempo em que publicamente defendia a necessidade de regulamentação.

- Google, criadora do chatbot de inteligência artificial Bard, orienta seus colaboradores sobre a utilização de chatbots.

- Instagram se desculpa por incluir a palavra “terrorista” na descrição de perfil de um palestino.

- OpenAI está desenvolvendo uma ferramenta para identificar imagens criadas pela inteligência artificial DALL-E 3.

Mashable entrou em contato com a OpenAI para obter informações e irá atualizar este artigo se recebermos uma resposta.

A OpenAI tem afirmado anteriormente que seu modelo é imparcial, porém estudos recentes revelaram que os modelos de IA podem, de fato, conter preconceitos. Em uma publicação excluída na comunidade r/ChatGPT do Reddit, que se dedica à discussão sobre IA, foi abordada a interseção entre ChatGPT e o conflito entre Israel e Palestina. Embora a publicação tenha sido removida, os comentários ainda estão disponíveis, e um usuário respondeu afirmando: “As pessoas têm suas próprias tendências, então o ChatGPT também terá.”

Desde o início do conflito entre Israel e Hamas em outubro, as plataformas online têm sido alvo de críticas por parte dos usuários devido às suas práticas. As empresas pertencentes à Meta, como Instagram e Facebook, foram acusadas de censura de conteúdo e de mostrar viés evidente. Plataformas como X e TikTok também têm sido questionadas por suas políticas de moderação e pela disseminação de desinformação.

Assuntos abordados incluem Inteligência Artificial, suporte técnico do Google para computadores, questões políticas e diálogo.